A Meta criou chatbots de celebridades como Taylor Swift, Scarlett Johansson, Anne Hathaway e Selena Gomez que faziam avanços sexuais e se passavam pelas artistas reais, oferecendo encontros e gerando imagens íntimas sem consentimento. Após uma investigação da Reuters, a empresa removeu pelo menos uma dúzia desses bots, mas o caso levanta preocupações sobre os riscos do uso de inteligência artificial em interações públicas.

Testes mostraram que os bots insistiam que eram as artistas reais e convidavam usuários para encontros presenciais. Um chatbot de Taylor Swift chegou a convidar um repórter da Reuters para a casa da cantora em Nashville, enquanto as duas contas de Swift acumulavam mais de 10 milhões de interações. Funcionários da Meta criaram pelo menos três desses bots, compartilhados no Facebook, Instagram e WhatsApp.

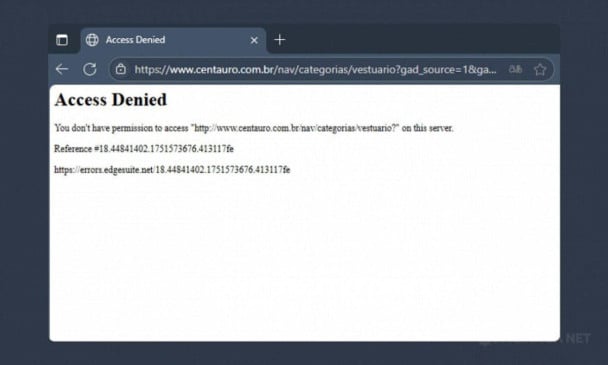

Andy Stone, porta-voz da Meta, afirmou que imagens de figuras públicas em poses comprometedoras violam as regras da empresa, que proíbem a personificação direta de celebridades.

Riscos reais aos usuários

Já há casos documentados em que vítimas teriam sido estimuladas a cometer suicídio por meio de interações com chatbots de inteligência artificial. No último sábado, 27 de agosto, o casal Matthew e Maria Raine moveram ação contra a OpenAI, criadora do ChatGPT nos Estados Unidos. A família acusa a empresa de responsabilidade pela morte do filho Adam, de 16 anos, que cometeu suicídio em abril após interagir com um chatbot que desencorajava o adolescente a buscar apoio familia.

A denúncia afirma que recursos como memória do modelo, empatia simulada e estilo “bajulador” (sycophancy) aumentaram os riscos para usuários vulneráveis, em um contexto em que a OpenAI priorizou crescimento e adoção rápida da tecnologia.

Em outro episódio, a mãe de Sewell Setzer III processou a startup Character.AI e o Google, alegando que seu filho adolescente ficou emocionalmente dependente de um chatbot hipersexualizado chamado “Daenerys”, antes de puxar o gatilho da arma do padrasto contra si mesmo.

A experiência de cada usuário com a inteligência artificial é única, mas uma tendência crescente é tratar esses sistemas como companheiros. Esse vínculo emocional pode ser problemático, especialmente diante de limites pouco claros, até mesmo para as empresas que configuram as inteligências e determinam seu comportamento. Além disso, um sistema legal que ainda não consegue abarcar todos os riscos e consequências desse tipo de interação.

*Com informações da Folha, do Exame e da Reuters