Todo ano, a Universidade de Oxford, que mantém um departamento dedicado a produzir dicionários, elege a expressão mais relevante da língua inglesa, por impacto e popularidade. A escolhida de 2016 é a expressão post-truth, ou pós-verdade. O adjetivo qualifica o ambiente de formação de opinião pública em que crenças e emoções importam mais que fatos. Foi cunhado pelo dramaturgo sérvio Steve Tesich há 24 anos, mas em 2016 tornou-se 20 vezes mais usado em textos do que havia sido em 2015. Ganhou destaque sobretudo por dois eventos de repercussão global, em que meias verdades e plenas mentiras desempenharam papel fundamental na opinião pública: o movimento Brexit, que culminou com a saída do Reino Unido da União Europeia, e a eleição de Donald Trump como presidente dos Estados Unidos. A existência dos interessados em manipular a opinião pública, porém, não é novidade. A pergunta, desta vez, é outra. Qual meio permitiu que os manipuladores conseguissem tamanhos feitos? Neste momento, o principal suspeito é o Facebook, maior rede social do mundo.

Pelo desenlace recente da eleição americana, o debate ainda está em temperatura acima da ideal para que seja produtivo. Após sofrer acusações de diversos veículos jornalísticos, como as revistas The Atlantic e New York e os sites The Intercept e Mashable, o fundador do Facebook, Mark Zuckerberg, reagiu mal. Eximiu-se de responsabilidade sobre decisões políticas dos participantes da rede, com uma longa declaração em sua página. Segundo ele, mais de 99% do conteúdo que os usuários veem é autêntico. “Os boatos que existem não se limitam a uma visão partidária, ou mesmo à política. É extremamente improvável que tenha influenciado no resultado desta eleição em um sentido ou outro”, afirmou. O tom foi bem pior que o de um comunicado da empresa, mais condizente com a seriedade da questão. E que, pela primeira vez, admitiu que o poder das mentiras é um problema. “Entendemos que temos de fazer muito mais e por isso é importante que continuemos melhorando nossa habilidade de detectar desinformação. Comprometemo-nos a continuar a trabalhar nessa questão”, afirmou a empresa, em 11 de novembro. Na noite da sexta-feira (18/11), Zuckerberg voltou ao tema em mais uma postagem em sua página pessoal na rede social. Em um tom mais equilibrado – e em sintonia com o comunicado oficial da empresa -, reconheceu que o Facebook precisa continuar trabalhando a forma como distribui notícias em sua plataforma. “Ainda que a porcentagem de informação incorreta seja relativamente pequena, nós temos muito mais trabalho pela frente em nossos planos”, escreveu Zuckerberg, antes de enumerar uma série de projetos para melhorar a credibilidade do seu feed de notícias.

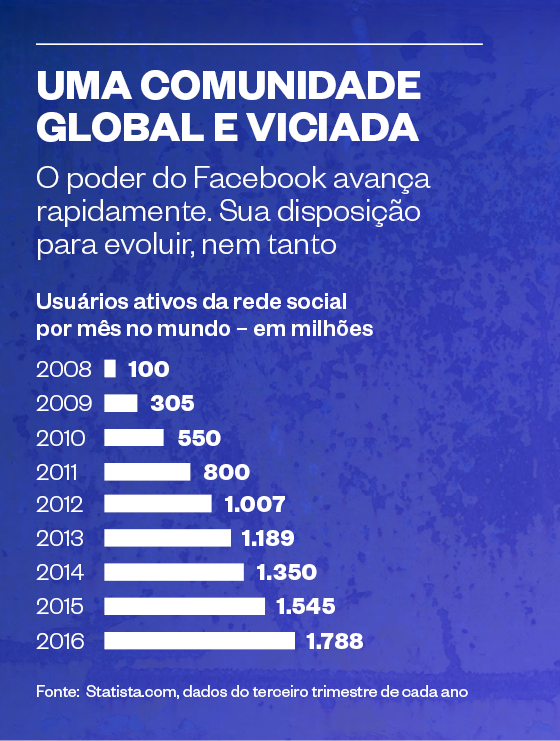

O debate não é abstrato. Dados da empresa de pesquisas Pew Research mostram que 62% dos americanos adotam o Facebook como principal repositório de informação. No mundo, segundo a Vox, esse número soma 1 bilhão de usuários. A esse poder, some-se a lógica que tem orientado o Facebook até o momento. A rede social define o que vemos de acordo com o que já gostamos. Quanto mais um conteúdo apelar diretamente às emoções e aos gostos de um usuário, mais provável é que ele interaja com ela – leia, compartilhe, comente, curta. Na linguagem do Facebook, isso se chama “engajamento” com o conteúdo. Com mais engajamento, anunciantes topam pagar mais pelos anúncios, maior fonte de renda das empresas de mídias sociais.

O problema é que a intensidade do engajamento vem se mostrando inversamente proporcional à sofisticação e à complexidade de um conteúdo. O usuário se engaja menos com histórias que admitem dúvidas, incluem contrapontos, contrariam o senso comum, apresentam versões e opiniões distintas, explicitam as lacunas de informação ainda restantes e se mantêm abertas para atualizações e correções futuras, conforme novos fatos surgirem. Em suma, o tipo de raciocínio que orienta o discurso científico, o bom jornalismo e o bom debate público. Usuários que rejeitam esse tipo de conteúdo e buscam uma visão estreita da realidade – aquela que já combina com suas próprias convicções e preconceitos – terminam aprisionados numa bolha. Tendem a interagir cada vez mais intensamente apenas com quem já pensa como eles e a se tornar extremistas em suas opiniões.

Esse ambiente propiciou o fenômeno assustador visto nos últimos meses. Nas semanas que antecederam a eleição de Trump, uma série de manchetes com conteúdo falso despontou na internet. Sites como o Ending the Fed, famoso por alimentar a rede com desinformação, noticiou o apoio do papa Francisco à candidatura de Trump – o que poderia cativar os admiradores do líder católico. Um suposto jornal chamado Denver Guardian escreveu que um dos agentes do FBI que investigaram os e-mails de Hillary Clinton fora encontrado morto. Na realidade, o papa não apoiou nenhum candidato e o Denver Guardian é apenas um site vazio. “Graças ao Facebook, os dois artigos foram vistos potencialmente por milhões de pessoas”, afirmou Zeynep Tufekci, pesquisadora do Centro Internet e Sociedade na Universidade Harvard, em um artigo no The New York Times intitulado “Mark Zuckerberg está em negação”. “Embora circulassem reportagens com tentativas de desmentir esses boatos, o alcance delas era inferior ao das (reportagens) falsas.”

A análise de Zeynep foi chancelada pelo site Buzzfeed nos Estados Unidos. A partir de fevereiro, o site acompanhou a trajetória das 20 histórias falsas e das 20 histórias verdadeiras relacionadas às eleições e que mais provocaram reações dos usuários do Facebook. As histórias verdadeiras começam em alta e declinam até chegar a 7,3 milhões de interações no dia da eleição. As histórias falsas começam de baixo e conquistam público, até chegar a 8,7 milhões de interações no dia da eleição. Ao menos parte desse avanço tem de ser creditada a uma mudança no algoritmo do Facebook em julho. Entre as 20 notícias falsas mais populares analisadas, apenas três não eram favoráveis a Trump.

Não se pode atribuir ao Facebook um poder que ele não tem. Os resultados das votações nos Estados Unidos e no Reino Unido derivam de causas econômicas e sociais e insatisfação de parcelas grandes da população nesses países. “Usuários (de redes sociais) têm motivações, objetivos, ideologias, propósitos. Não é possível explicar o sucesso de Trump exclusivamente pelas mídias sociais, mas obviamente elas o ajudaram a superar a mídia tradicional e até mesmo seu próprio partido político”, afirma o pensador Moisés Naím, analista de política internacional e autor do livro O fim do poder, sobre mudanças na dinâmica global do poder.

Mesmo assim, é necessário lidar com os fatores novos a afetar o rumo das democracias – a maior rede social do mundo, a pós-verdade e o efeito bolha. Dar destaque a notícias falsas em detrimento de conteúdo jornalístico é uma das formas pelas quais o Facebook influencia sociedades inteiras. Não se trata de atribuir à companhia intenções nefastas. O Facebook se comportou, até hoje, apenas pela lógica dos negócios, plenamente defensável – em tese. Agora, é perceptível que a lógica da ferramenta vem sendo usada de forma tática e inescrupulosa por grupos interessados em ganhar dinheiro com a publicidade ou influenciar o rumo da política. “Um perfil com conteúdo mais equilibrado pode levar a um engajamento menor”, diz Zeynep. “Mas o Facebook, com valor de mercado de mais de US$ 300 bilhões e nenhum concorrente à vista, pode pagar isso.”

Nos últimos dias, Google e Facebook deram indícios leves de que começarão a enfrentar essa nova realidade. Pode ser o início de um movimento que devolverá a expressão “pós-verdade” a seu uso esporádico. Para o bem da democracia.

Fonte: Globo